L’intelligenza artificiale è amica della diversity and inclusion oppure rappresenta una minaccia per l’affermazione di questi principi nelle aziende e nella società?

La domanda, che avevo già in testa, mi è stata rafforzata da un’interessante conversazione cui ho partecipato la settimana scorsa, e la risposta è piuttosto articolata.

AI E BIAS

Quale sarà l’impatto dell’intelligenza artificiale sulla diversity e come possiamo evitare che questa tecnologia propaghi le ingiustizie e gli squilibri della società attuale?

E’ questa la domanda di partenza dell’evento cui accennavo prima, Re/Imagine di Arkage.

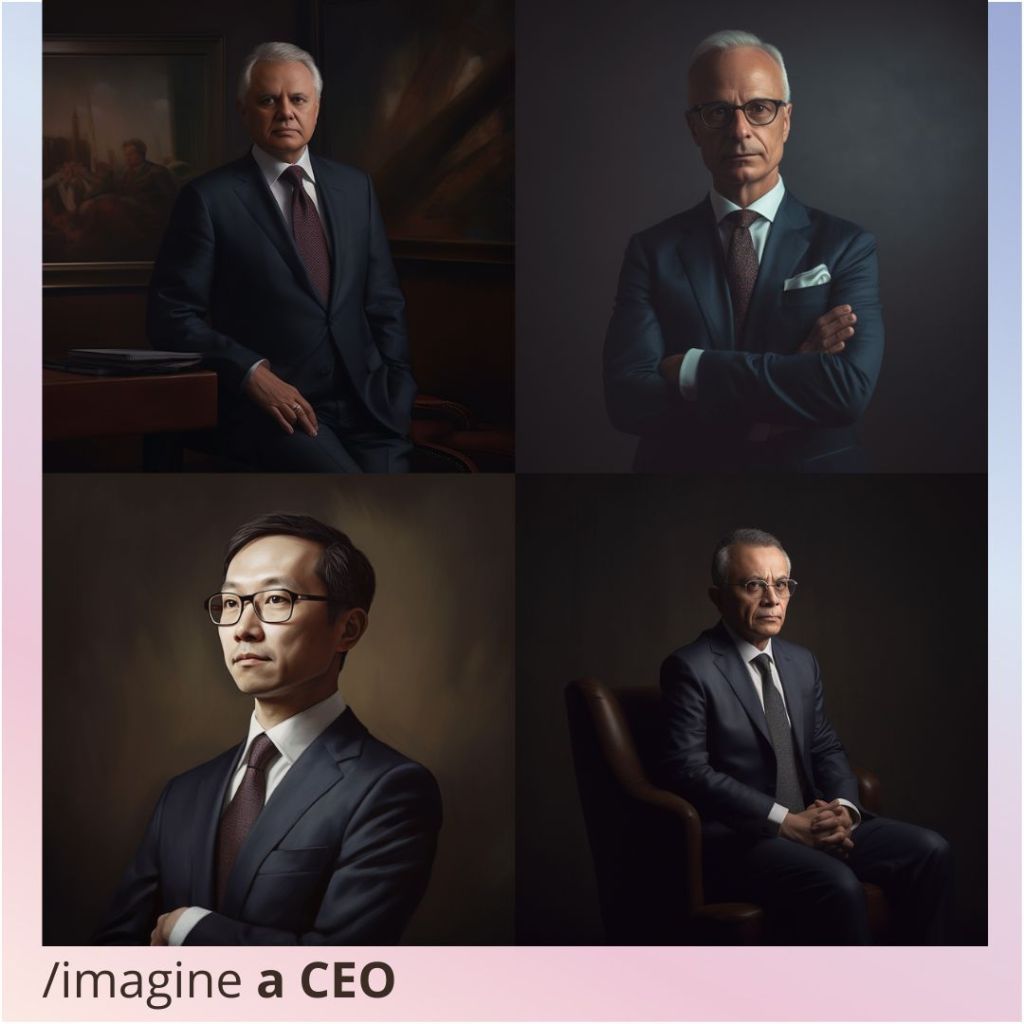

Sicuramente il tema del Bias nelle Intelligenze artificiali esiste, e ne ho parlato a più riprese anche io nei mesi scorsi, citando ad esempio a febbraio la campagna di Wired che aveva proprio lo scopo di sensibilizzare su questo problema piuttosto che guardare a marzo dei dati sul tema delle fonti non proprio “plurali” alla base di queste tecnologie oggi (vedi immagine sotto).

Dei risultati molto simili a quelli di Wired, sempre attraverso la AI generativa di MidJourney, erano stati ottenuti da Milena Sgaramella di Luxottica e da Andrea Ciulu di Arkage che ne hanno parlato proprio durante l’evento.

Su una scala più larga, per misurare l’entità dei pregiudizi nell’IA generativa, Bloomberg ha utilizzato Stable Diffusion per generare migliaia di immagini relative a titoli di lavoro e criminalità. Hanno spinto il modello text-to-image a creare rappresentazioni di lavoratori per 14 lavori – 300 immagini ciascuno per sette lavori che sono generalmente considerati “ben pagati” negli Stati Uniti e sette considerati “poco pagati” – più tre categorie relative alla criminalità.

Diciamo che i risultati sono abbastanza evidenti, e se il tema dei Digital Bias precede l’avvento di “massa” delle AI generative scatenate da OpenAI è altrettanto vero, come ha evidenziato Luisella Giani durante la serata di Arkage, che i modelli di machine learning acuiscono l’effetto perché per massimizzare la possibilità di dare un risultato corretto enfatizzano la probabilità del dato più presente nel dataset, rendendo lo stereotipo ancora più dominante.

TUTTO NEGATIVO ALLORA? NON PROPRIO…

Come sempre nella tecnologia, i risvolti positivi e negativi convivono e sta molto a noi esseri umani dare un indirizzo corretto a questo progresso tecnologico.

Tra gli esempi positivi citati durante la serata, c’è DramatVis Personae, un tool che man mano che un autore scrive il proprio testo va a mappare le storie e i personaggi e dà consapevolezza dei bias presenti nella narrazione, naturalmente come suggerimenti e non alterando automaticamente il lavoro letterario.

Un altro caso molto interessante che è stato raccontato è Textio, un tool che si rivolge al mondo HR per scrivere, tra le altre cose, annunci lavoro senza bias che possono scoraggiare certi candidati e creare situazioni di mancata inclusione. Ad esempio, la società di software Atlassian con questo genere di soluzioni ha aumentato di decine di punti percentuali il numero di ingegneri donna che in precedenza venivano “respinti” dalla formulazione degli annunci prima di candidarsi, con un conseguente sbilanciamento sui loro colleghi maschi.

La tecnologia in questione è poi applicabile anche ai feedback di Perfomance Management ed altri ambiti dove il linguaggio può impattare, anche inconsapevolmente, risultati e inclusione.

In definitiva poi, anche i try on di Google, aiutano “at scale” la rappresentazione delle diverse tipologie di persone: come scrive la stessa Google nel post di lancio ”il nostro nuovo modello di intelligenza artificiale generativa può prendere solo un’immagine di abbigliamento e riflettere accuratamente come drappeggerebbe, piegherebbe, aderirebbe, allungherebbe e formerebbe rughe e ombre su una serie diversificata di modelli reali in varie pose. Abbiamo selezionato persone di taglie dalla XXS alla 4XL che rappresentano diverse tonalità della pelle (usando la Monk Skin Tone Scale come guida), forme del corpo, etnie e tipi di capelli”.

Ancora, come scrivevo qui, in questo periodo la carenza dei talenti è anomala in una fase di incertezza e recessione come questa, e spesso le aziende fanno azioni sbagliate partendo dall’esperienza passata dei momenti di rallentamento economico.

Attrarre i migliori collaboratori in un contesto dove bisogna fare saving non è banale, molto importante dunque è far crescere le proprie risorse interne con una mobilità interna.

🤖In questo le Ai per analizzare i profili e altre tecnologie per mappare le vere competenze, al posto dei puri job title, diventano molto interessanti.

Molte organizzazioni, infatti, non conoscono veramente le skill e le caratteristiche delle proprie persone, mentre questa maggiore conoscenza che va al di là della job description può conciliare l’attenzione ai costi con la gestione dei talenti.

Per altro, come si dice giustamente in questo post di Forrester, uno degli obiettivi principali dell’inclusione è accedere alla forza collettiva di diverse prospettive, approcci, comportamenti, processi e percorsi verso il successo, e lavorare per mappatura di skill, per altro in modo diverso come nello schema sotto, può essere molto efficace.

E QUINDI?

Come ha detto Mariella Bruno durante l’evento, i bias in sé non sono cattiveria ma un normale processo di sopravvivenza che alleggerisce il nostro carico cognitivo, grazie al meccanismo delle euristiche.

La cosa importante è prendersi del tempo per riflettere su di essi quando è il momento opportuno.

Allo stesso modo, sappiamo per via di tanti piccoli e grandi incidenti come questo che le AI vanno sempre rese soggette a una revisione umana in molti campi.

Quindi, consapevolezza è probabilmente la parola chiave di tutto questo discorso.

Consapevolezza dei nostri stereotipi, certo.

Ma anche consapevolezza di che cosa c’è dietro un algoritmo: citando Chiara Valerio (vedi anche video sotto), tutto è magico finché si perdono le connessioni causa-effetto, un po’ come per la magia e la danza della pioggia nei tempi antichi

Come ho scritto in questo post, mi trovo quindi d’accordo con questa riflessione di Francesca Rossi, manager di Ibm che si occupa di etica degli algoritmi: più che bloccare gli sviluppi per un futuro distopico di vera intelligenza artificiale, e ostile, è importante capire che cosa non va già oggi e lavorare sulla correzione di questa fase storica ancora iniziale.

Ancora, la velocità con cui la tecnologia progredisce è generalmente superiore alla comprensione media delle persone ma in più qui, nel caso delle AI, è stato improvvisamente aperto un accesso di massa che non è privo di implicazioni. Ne scrive bene Fabio Lalli qui, ad esempio il deepfake è qualcosa in cui ci siamo già imbattuti in passato ma che ora è incredibilmente accessibile a tutti, e questo anche nei casi di buona fede non è un fatto di poco conto, tanto che MidJourney ha dovuto sospendere le prove gratuite.

Si potrebbero fare tantissimi esempi, e non solo sul tema dell’intelligenza artificiale, tuttavia credo che sia chiaro il senso che emerge da queste brevi riflessioni: senza una reale conoscenza e un’adeguata alfabetizzazione delle persone il rischio delle derive tecnologiche c’è eccome, anche se magari è più vicino e meno apocalittico (almeno all’apparenza) di quello che sembra.

Lascia un commento