Come sta evolvendo davvero l’intelligenza artificiale generativa e quanto successo ha davvero?

Una domanda che non ha una risposta così semplice come sembra.

E, soprattutto, che non si dovrebbe cercare solo nelle singole applicazioni più famose.

QUALCHE NUMERO

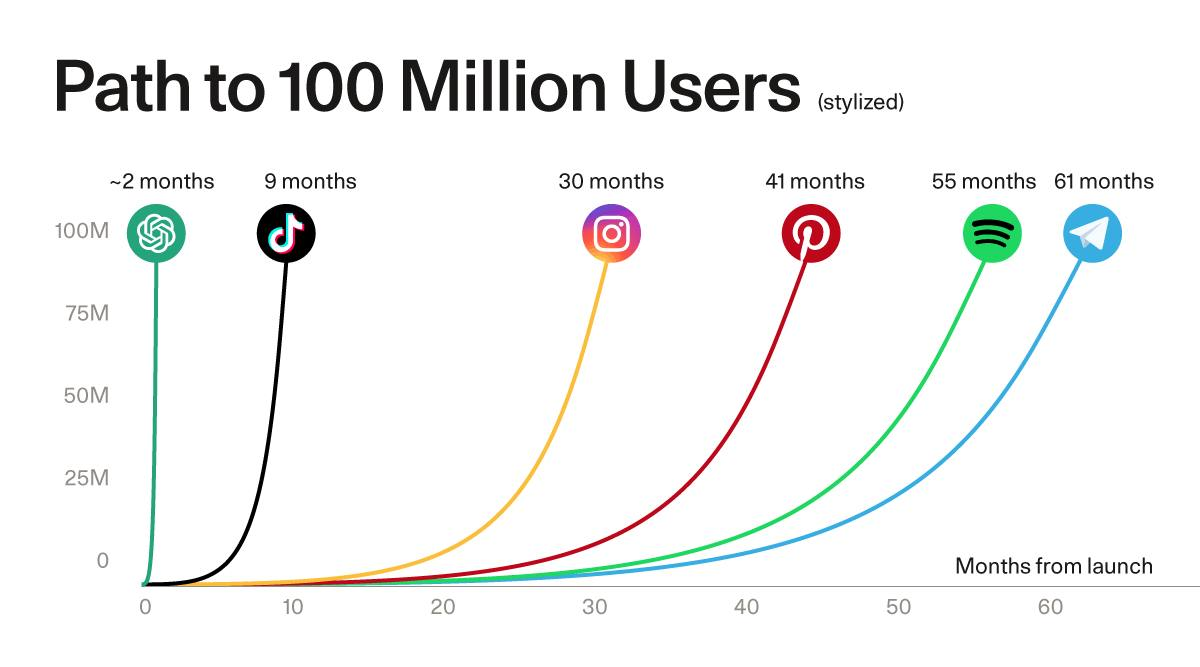

Di sicuro l’adozione di questi strumenti è stata incredibilmente veloce, basti pensare a quanto ha impiegato ChatGpt a raggiungere i 100 milioni di utenti rispetto ad altre soluzioni digitali che contano numeri simili (vedi immagine sotto).

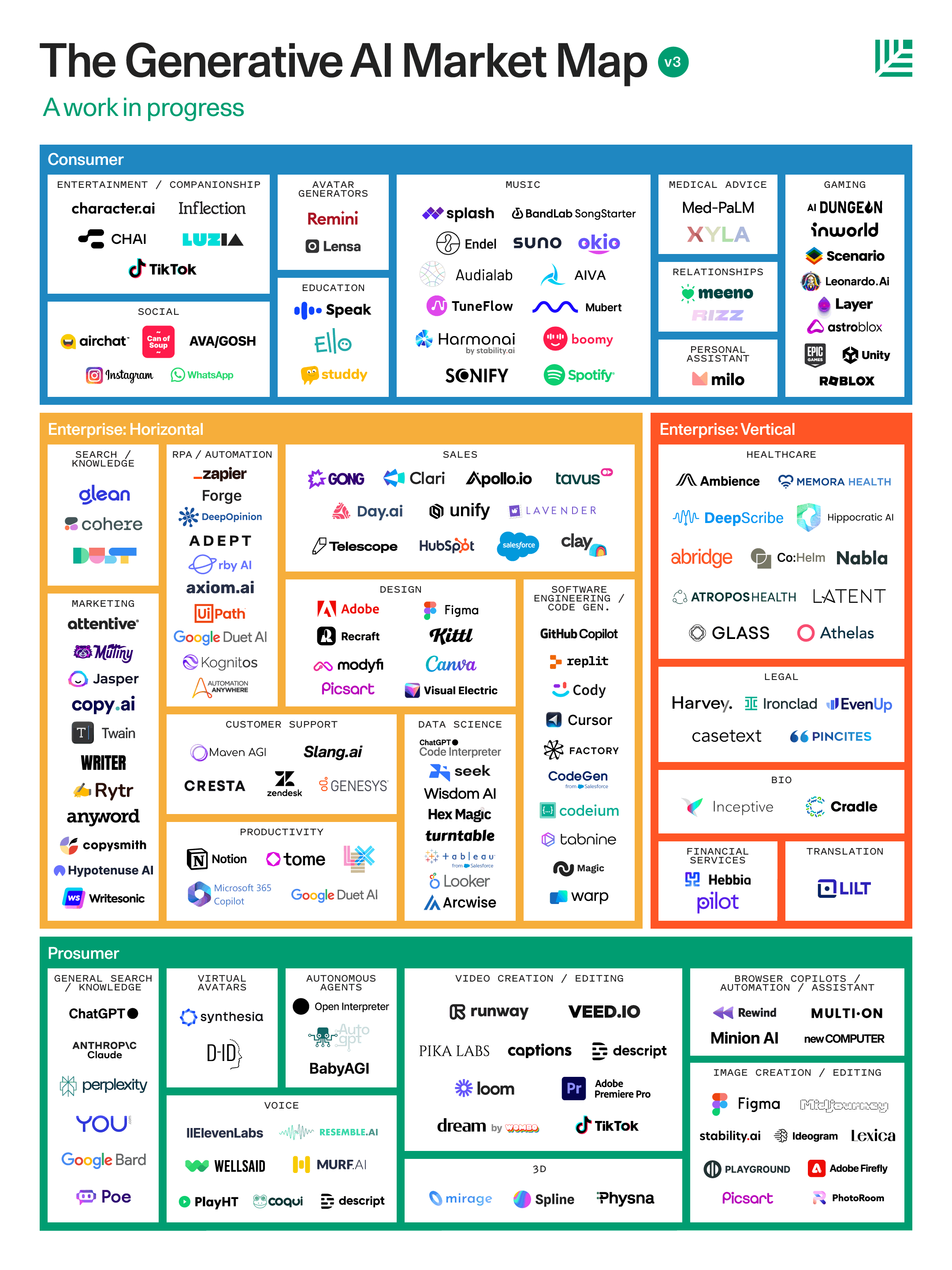

Inoltre il mercato che si è generato, per quanto ancora in divenire, ha dato vita ad un landscape particolarmente articolato che si contende le attenzioni di pubblico e aziende.

Fonte: https://www.sequoiacap.com/

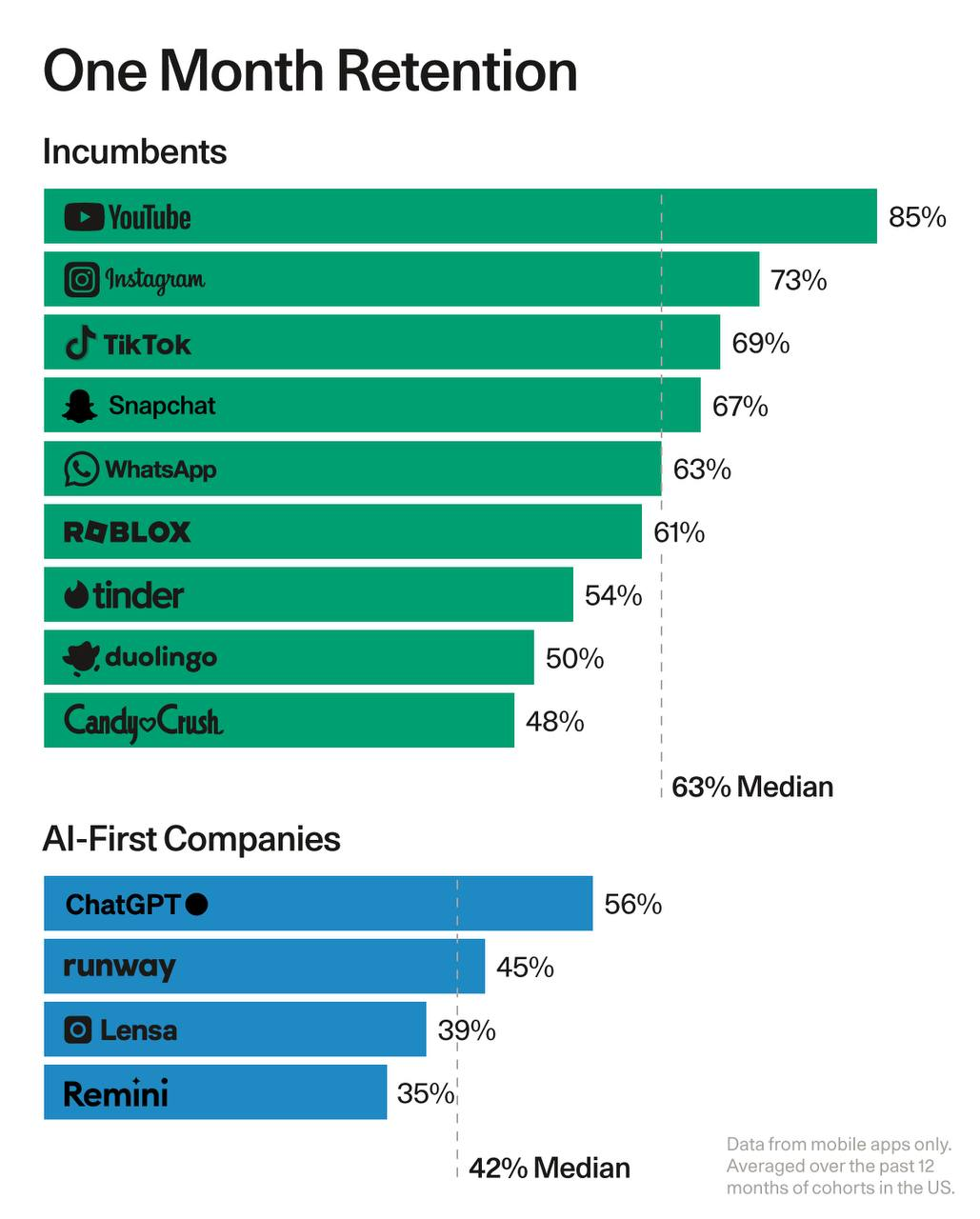

Allo stesso tempo, le app di intelligenza artificiale generativa faticano a mantenere gli utenti ingaggiati: il grafico seguente mette a confronto la fidelizzazione delle app mobili al mese 1 delle applicazioni AI-first con quelle delle aziende esistenti.

Anche il rapporto tra daily user attivi che sono anche lo sono anche su base mensile non è particolarmente positivo. Alcune delle migliori aziende di consumo hanno il 60-65% nel rapporto DAU/MAU e quello di WhatsApp è dell’85%.

Al contrario, le app di IA generativa hanno una mediana del 14% (con la notevole eccezione di Character e della categoria “AI companionship”). Ciò significa che gli utenti non trovano ancora abbastanza valore nei prodotti di intelligenza artificiale generativa per utilizzarli ogni giorno.

GPT-4 ha fatto grandi passi avanti al suo rilascio nel marzo 2023, ma, come scrive Techopedia, delle crepe nella superficie stanno iniziando a mostrarsi, con il traffico di ChatGPT che è diminuito del 9,7% a giugno.

A ciò si aggiunge uno studio pubblicato dalla Stanford University a luglio ha rilevato che le prestazioni di GPT-3.5 e GPT-4 in numerose attività sono “sostanzialmente peggiorate nel tempo”, tanto che anche in Italia echeggia la domanda se ChatGPT sia diventato più “stupido” e Francesco Marino su La Repubblica dice di no ma che probabilmente il sistema è cambiato per una serie di regioni anche tecniche, mentre lo stesso VP del prodotto di OpenAi Welinder scrive in un Tweet: “No, we haven’t made GPT-4 dumber. Quite the opposite: we make each new version smarter than the previous one. Current hypothesis: When you use it more heavily, you start noticing issues you didn’t see before”.

Dietro le esigenze di evoluzione dei software primeggiano probabilmente quelle di sostenibilità economica: le AI (come il cloud che le ospita) hanno fame di hardware fisici per poter funzionare, e i costi di esercizio sono tutt’altro che modesti!

Le GPU di Nvidia (sì quella “semisconosciuta” 🙂), essenziali per lo sviluppo di modelli linguistici di intelligenza artificiale, sono dunque molto richieste in tutto il mondo. Secondo Jing Finance Tech, i giganti della tecnologia cinese Baidu, ByteDance (TikTok), Tencent e Alibaba hanno ordinato processori A800 per un valore di 1 miliardo di dollari da Nvidia, con consegna prevista entro la fine dell’anno. Si sono inoltre assicurati 4 miliardi di dollari in GPU (unità di elaborazione grafica) per la consegna nel 2024. Alibaba Cloud, in particolare, ha acquisito migliaia di chip H800 da Nvidia per rafforzare i propri servizi cloud. La GPU A800, una variante dell’avanzata GPU A100 di Nvidia, è stata introdotta per il mercato cinese in conformità con le restrizioni all’esportazione statunitensi, che limitavano la velocità di trasmissione dati delle GPU vendute in Cina.

Ma allora la rivoluzione di #ChatGPT è un’altra fantasia tecnologica e ha ragione chi, come The Verge, parla di un “boom already over” (e la reale prospettiva del campione della notorietà di queste tecnologie, ChatGPT, viene messa in dubbio da altre fonti)?

Di certo, anche chi legge questo picco in modo meno netto, come potete ad esempio ascoltare in questo podcast, non manca di sottolineare che serve un giusto equilibrio tra aspettative e possibili barriere al successo.

Ma è proprio qui che arriviamo al vero nocciolo della questione.

IL PUNTO NON È LA AI GENERATIVA, MA IL FATTO DI VEDERLA COME UNA COSA A PARTE

Il punto è che una app standalone che fa una sola cosa è sicuramente utile ma non ha ancora quel senso intrinseco per i clienti tale da diventare un’abitudine quotidiana.

Siamo solo all’inizio, è vero, ma la strada giusta, secondo me, è quella che unisce i puntini e usa la Ai generativa dentro altri prodotti, cosa certo non nuova per la AI non generativa, offrendo grandi grandi benefici sulla produttività.

Gli esempi, per fortuna, iniziano ad essere molti, ed ecco una serie non esaustiva di video che lo testimoniano.

Adobe con le soluzioni di ritocco di immagini, video e testi

Dall-E incorporato dentro Bing

Bard di Google che aggiunge varie estensioni per altri software

YouTube e Spotify che usano la AI per le traduzioni

Roblox con “Everyone becomes a creator!” (lanciata il 17 febbraio e che trovate a questo link oltre che illustrato nel video sotto).

Meta con i suoi annunci, il primo con il nuovo Quest

Sempre Meta, con i suoi Ray-Ban

Di sicuro quindi la AI non può essere ridotta ad una singola applicazione, nemmeno quella di maggior successo che all’improvviso nel novembre 2022 (sì, meno di un anno fa) ha reso improvvisamente disponibile su larga scala e con una qualità mai sperimentata prima dal grande pubblico il frutto di una serie di tecnologie che hanno un percorso storico molto più lungo.

In questo podcast di Forrester si discute proprio di questi concetti, dicendo che tutte le varie sfide tecnologiche e trasformative vanno viste in una maniera organica (leggete ad esempio questo post sul “Metaverso Industriale”).

E devono ancora dimostrare il loro pieno valore.

QUESTE TECNOLOGIE SONO QUI PER EVOLVERE E RESTARE

Sia chiaro a scanso di equivoci che io credo che la AI, generativa e non, offra grandi benefici sulla produttività, come si dice bene in questo podcast di McKinsey la difficoltà però è quella di scalare i casi di uso e di calare nell’organizzazione gli esempi in modo pratico e realistico.

Finora, come viene argomentato bene qui, abbiamo vissuto una fase iniziale molto tech driven, mentre ora dovremmo aspettarci una fase più people driven e maggiormente integrata.

Le sfide in tal senso non mancano; Forrester, nel suo report Global AI Software Forecast, 2023 To 2030, prevede che nel breve termine i vantaggi in termini di produttività saranno ridotti dalle attuali limitazioni della tecnologia: mancanza di chiarezza normativa, domande sui diritti di proprietà intellettuale, modelli etici e pregiudizi e algoritmi che producono “allucinazioni”.

Ma alla fine, secondo lo stesso report l’utilizzo e l’efficacia dell’intelligenza artificiale generativa la faranno avanzare, con un tasso di crescita medio annuo del 36% fino al 2030, catturando il 55% del mercato del software AI.

Questa crescita senza precedenti sarà guidata da:

1) Adozione specializzata. Entro il 2030, 79 miliardi di dollari verranno spesi ogni anno in applicazioni specializzate progettate per migliorare l’automazione e aumentare la produttività, in particolare nei settori della sicurezza, della salute e del content marketing (si pensi a GitHub Copilot e Replit per il codice o alla sanitaria domiciliare di Cera che usa l’intelligenza artificiale generativa per creare contenuti visivi che spiegano concetti medici complessi in modo semplice). Senza poi contare le verticalizzazioni per il CRM o l’advertising.

2️) Adozione generalizzata. Entro il 2030, 42 miliardi di dollari saranno spesi ogni anno in casi d’uso generalizzati, come strumenti di ricerca, scrittura e sintesi. Oltre il 50% di questa spesa sarà destinato a chatbot e piattaforme di comunicazione. Twilio ha usa la AI generativa per migliorare le conversazioni dei team di vendita e marketing attraverso un servizio personalizzato senza cookie che crea profili dei clienti da riepiloghi post-chiamata e analisi del sentiment. Duolingo ha introdotto un nuovo livello di abbonamento “Max” che utilizza GPT-4 per due nuovi chatbot, uno che spiega le risposte errate di un utente e l’altro che funge da tutor di gioco di ruolo.

3️) Nuovi ricavi aziendali. La proliferazione dell’intelligenza artificiale generativa aprirà nuove opportunità di guadagno anche per le aziende che non utilizzano l’intelligenza artificiale generativa per l’automazione o lo sviluppo di prodotti. Stack Overflow intende iniziare a far pagare agli sviluppatori di intelligenza artificiale l’accesso alle domande e alle risposte sul suo sito mentre la citata NVIDIA vola poiché i suoi chip GPU vengono utilizzati per addestrare i modelli.

Di sicuro restano vivi i dibattiti sull’impatto delle AI generative sul mondo del lavoro (in Italia come negli USA), sui motori di ricerca e sull’overload di contenuti, tuttavia io resto sempre dell’idea che certi fenomeni restino ricorrenti nel tempo, che occorre capire a fondo, senza paura e ansia, e che solo unendo tutti i puntini potremo governare al meglio gli impatti.

Dal punto di vista aziendale, per concludere, non bisogna sottovalutare come al solito l’organizzazione: ogni nuova ricerca lo conferma, i silos sono i principali nemici dell’innovazione e non bisogna crearne di nuovi per le tecnologie emergenti.

Così come le applicazioni di AI generativa stanno all’interno di altri programmi, allo stesso modo l’innovazione deve pervadere in modo capillare l’organizzazione in modo concreto e utile.

Lascia un commento